간단하고 짧으며 크게 다양하지는 않은 task는 작은 set의 데모를 offline learning하는 것이 가능하지만,

엄청 다양하면서 긴 시간동안 많은 데이터를 요구하는 task는 fixed batch of data로 학습하는 것이 힘들다.

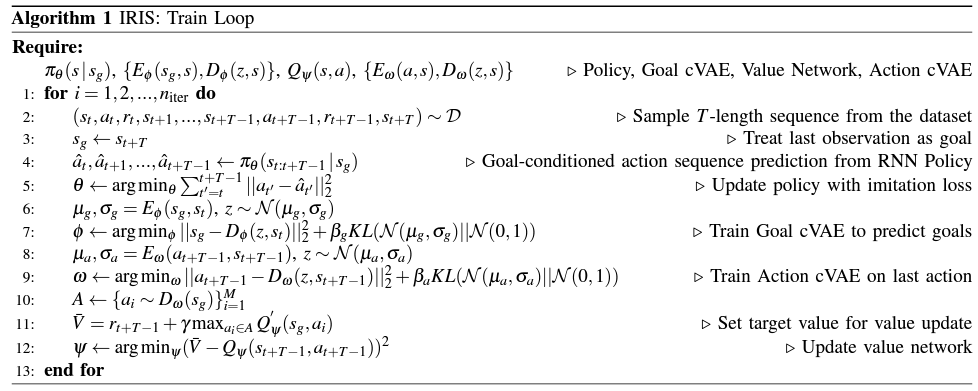

그래서 짧은 시퀀스를 따라하는 goal-conditioned low-level controller와 low-level을 위한 goal을 고르면서 적당히 suboptimal solution을 조각조각 조합하는 high-level goal selection을 구성하였다.

# Experiments

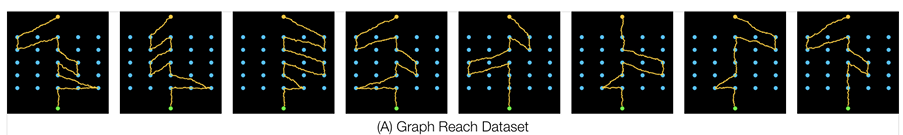

1. Graph Reach - a pedagogical example

매 에피소드마다 고정된 start, goal location이 있고 거기서 2D navigation을 하는 태스크다.

5x5 grid 이고 중심 path에서 벗어날 때마다 길게길게 돌아오도록 하였다. 그래서 imitation을 할 때 특정 파트만 골라서 해야 optimal performance를 할 수 있다. 평균 3844 timestep을 가지는 250개 demonstration을 이용하였다.

2. Robosuite Lift - suboptimal demonstrations from a human

Sawyer robot arm이 테이블 위의 큐브를 잡고 들어올리는 태스크이다. roboturk를 이용하여 수집하였고, 성공하는 demo 외에도 헛손질 하는 경우들을 많이 수집하였다. 평균 622 timestep의 137개 demo를 수집하였다.

3. RoboTurk Can Pick and place - Crowdsourced Demonstrations

1100개 demo 중 빠른 순으로 225개를 골라 사용하였다. 여러 사람이 참여하여 모았기에 optimality, diversity가 여러종류이고 평균 589 timestep이 걸린다. 캔을 쓰러뜨린 후 줍는 사람도 있고, 로봇 팔을 캔 위로 하여 위에서 집는 사람도 있었다.

IRIS, no Goal VAE는 VAE 대신 deterministic goal prediction network가 사용된 경우고, IRIS no Q는 goal selection을 그냥 Goal VAE sampling으로 한 경우이다.