1. tiny-cuda-nn 설치. (필수는 아니지만, 건너뛰려니까 쿠다관련 에러가 많이 떠서 겸사겸사 옵션들을 다 설치해보았다..)

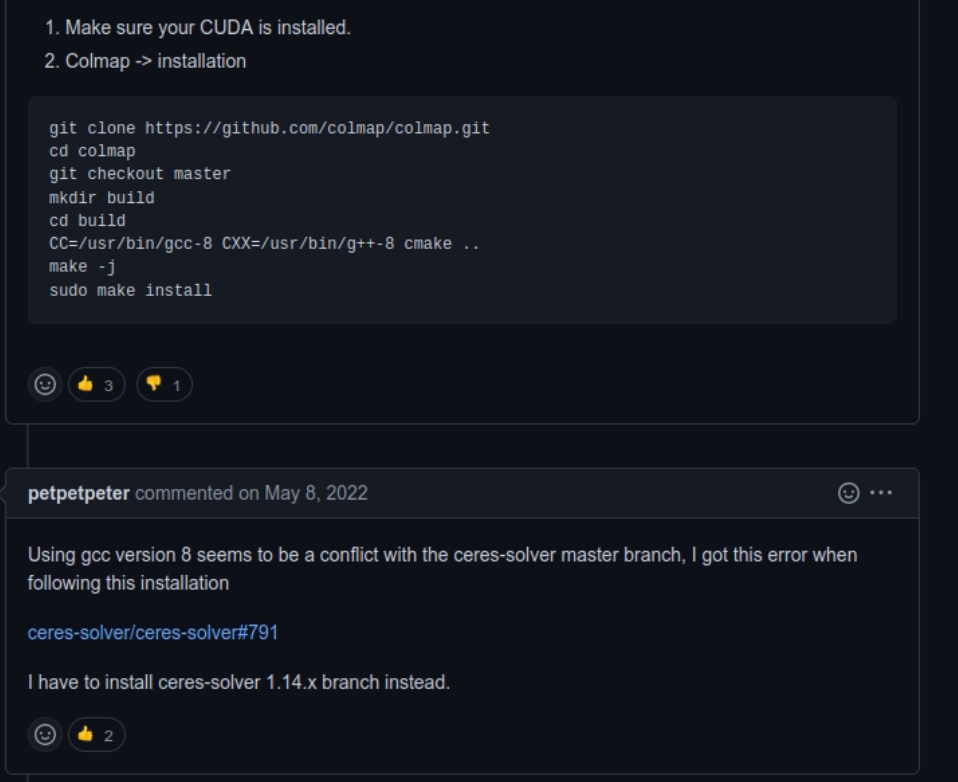

- gcc version, cmake version 을 올려야했다.

- 일단 cmake version 올리기. 밑의 블로그 참고했고, https://cmake.org/files/v3.21/ 여기서 tar.gz 파일 받아서 압축해제하고,

./bootstrap --prefix=/usr/local

make

sudo make installhttps://eehoeskrap.tistory.com/397

[CMake] Ubuntu에 CMake 설치하기

1. apt 를 이용한 설치 (구버전이 설치됨) $ sudo apt install cmake 2. 직접 최신버전 설치 2.1 홈페이지에서 다운로드 https://cmake.org/download Download | CMake Current development distribution Each night binaries are created as

eehoeskrap.tistory.com

진행하면 된다. 중간에 openssl이 설치되어있지 않다는 오류가 떠서, openssl 설치하고 다시 bootstrap 했더니 순조롭게 진행중.

sudo apt-get install libssl-dev-- gcc 도 업그레이드 했다. 밑의 사이트를 참고하면, 여러 버전의 gcc를 설치해놓고 우선순위를 정해놓으면 같이 쓸수 있나보다!

https://nautiluslee.blogspot.com/2019/11/ubuntu-1804-gcc.html

근데 cuda version이 11.7 이상이어야 가능한 것이었다.. 70이상이라길래 뭔말인가.. 무시했더니 11.7 이상이란 뜻이었음.. ㅎ

그런데 nvcc -V 랑 nvidia-smi 버전에 다 11.7 이어도 에러가 났다. 그건 nvidia-cuda-toolkit 을 apt-get 으로도 깔면 run 파일로 설치한 것이랑 공존하게 되는데, apt-get 이 예전버전으로 설치가 되므로 (10.1?) 그것을 nvcc 가 감지해서 그걸 우선순위로 사용하기 때문이었다. 아무튼 그래서 밑의 issue 에서 언급하듯 그걸 삭제한 후, bashrc 에 있는 LD_LIBRARY_PATH, PATH를 제대로 설정했는지 체크하고, build 폴더를 삭제하고 다시 build 하면 멀쩡하게 작동한다.

https://github.com/NVlabs/instant-ngp/issues/747

https://github.com/NVlabs/instant-ngp/issues/1044

그렇게 설치를 마치고서, pytorch 버전의 tcnn을 설치한다.

pip install git+https://github.com/NVlabs/tiny-cuda-nn/#subdirectory=bindings/torch2. 다시 torch-ngp 로 돌아와서, 그다음 extension 들을 설치한다.

https://github.com/ashawkey/torch-ngp

'Experiments' 카테고리의 다른 글

| nerf-supervision github 설치하기 (0) | 2022.12.28 |

|---|---|

| git commit 할때 파일 빼기 (0) | 2022.03.01 |

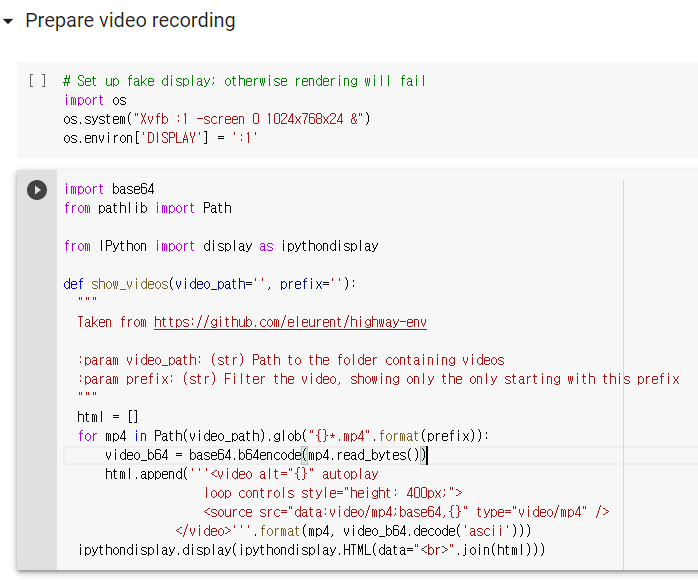

| mujoco 150 설치하기. Ubuntu 18.04에서. (0) | 2022.01.19 |

| 고통의 3D spacemouse UR5와 연결하기. (0) | 2022.01.04 |

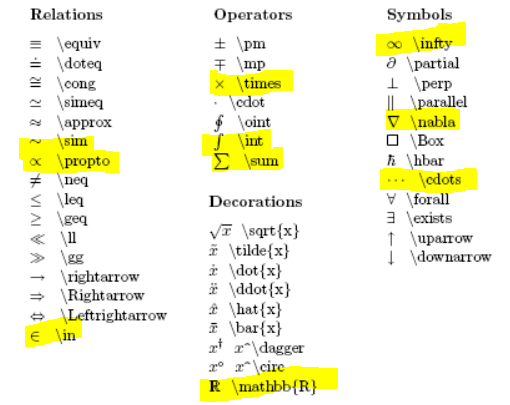

| Latex 자주 쓰는 모음 정리 (2) | 2021.12.18 |